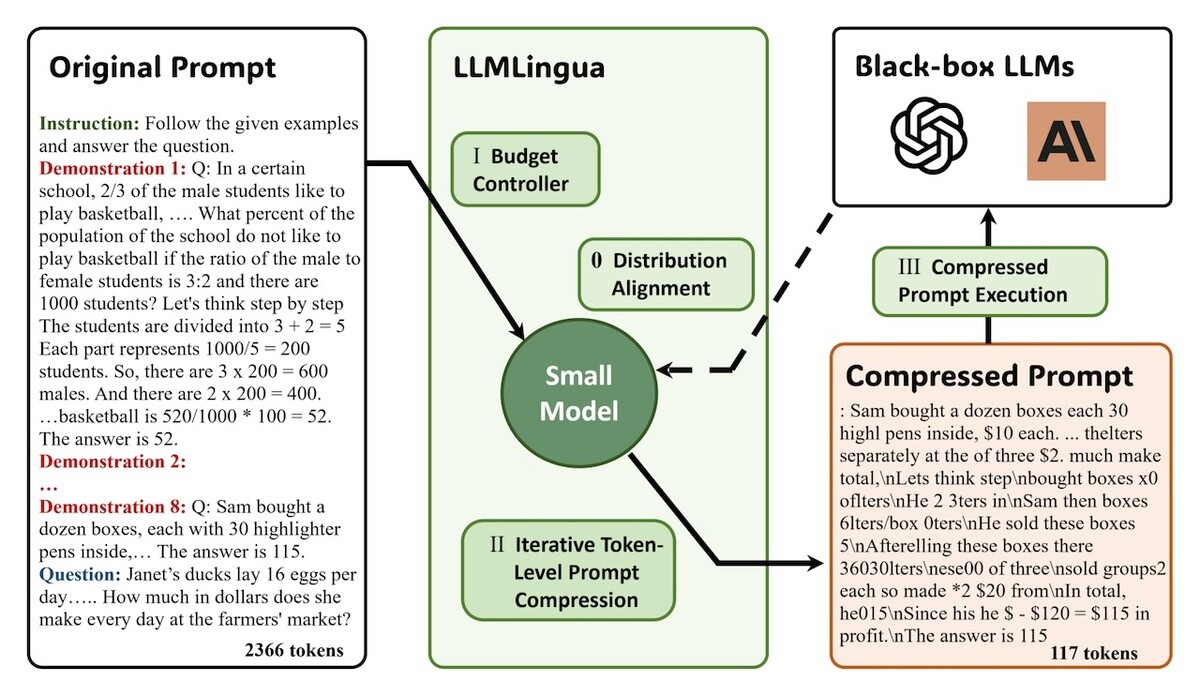

Microsoftの研究者は12月7日、Microsoft Research Blog「LLMLingua: Innovating LLM efficiency with prompt compression」において、大規模言語モデル (LLM) に与えるプロンプトを高度に圧縮する新技術「LLMLingua」を発表した。LLMからより高精度の回答を引き出そうとすると、入力するプロンプトはどうしても長くなりがちだ。LLMLinguaを利用すると、長いプロンプトを意味を保持したまま大幅に短縮することができる。

LLMの出力の品質は入力するプロンプトに依存している。より高品質な回答を得ようとすれば、プロンプトが非常に長くて複雑なものになることもある。LLMLinguaでは、GPT2-smallやLLaMA-7Bといった、十分にトレーニングされた小規模言語モデルを利用することで、入力されたプロンプトの中から重要でないトークンを識別して削除する。その結果、プロンプトは人間には理解が難しくなるが、LLMにとっては非常に効率的なものになる。この圧縮されたプロンプトをLLMに渡した結果、元のプロンプトと同等の出力を得ることができたという。

LLMLinguaでは、圧縮にあたって言語の整合性の維持に細心の注意を払っているため、重要な情報を保持したままで安全に不要なトークンを取り除くことができると研究者は説明している。加えて、LLMLinguaを使うことで、LLMの応答速度も20から30%の範囲で大幅に向上することも証明できたとのこと。さらに、圧縮されたプロンプトに対してGPT-4を使用して復元を試みたところ、すべての主要な推論情報が正常に復元することができたという。小規模言語モデルにる圧縮で取り除かれた情報が、LLMを利用することで復元できるというのは極めて興味深い。

Microsoftの研究者は、専用のプロジェクトサイトを立ち上げてLLMLinguaについて詳しく解説している。

LLMLingua | Designing a Language for LLMs via Prompt Compression

また、LLMLinguaのソースコードや実行手順はGitHubリポジトリで公開されている。